Die Herausforderung

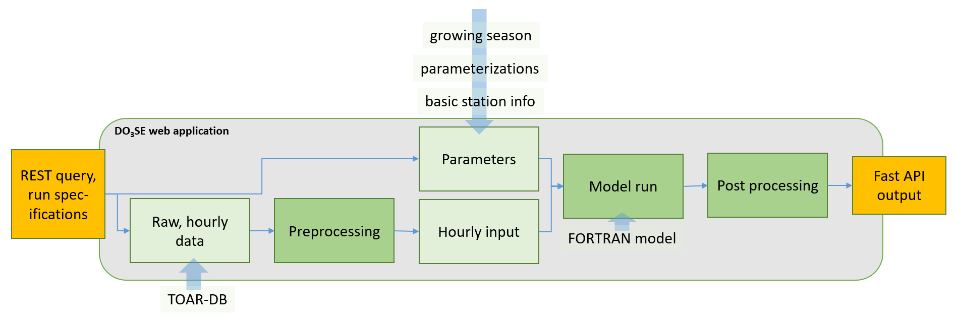

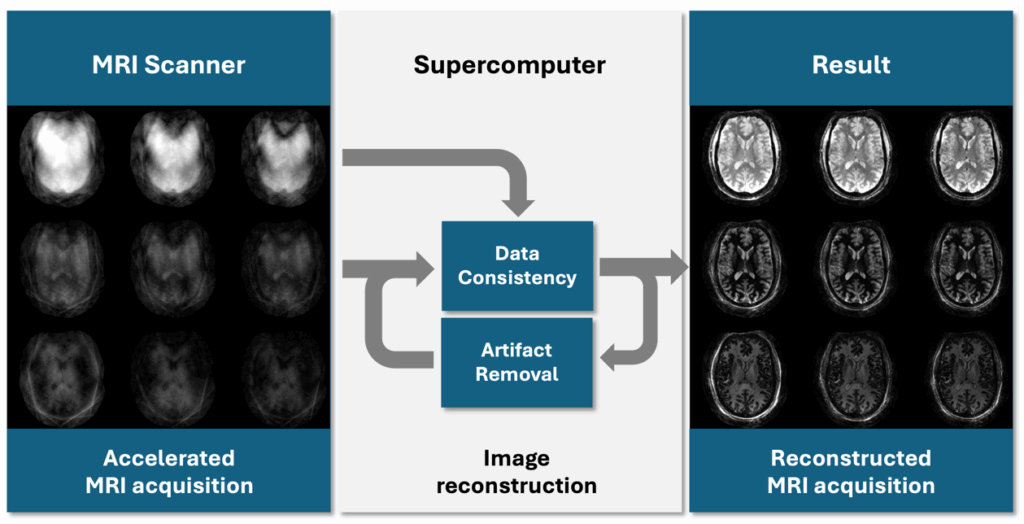

Die quantitative Magnetresonanztomografie (qMRT) misst zugrunde liegende MRT-Parameter, verbessert die Empfindlichkeit gegenüber physiologischen Veränderungen und ermöglicht eine zuverlässige Vergleichbarkeit zwischen Tests und Wiederholungstests, sodass beobachtete Veränderungen echte physiologische Unterschiede widerspiegeln und nicht die Kulanz des Scanners. Die Übertragung der qMRT auf UHF, die eine höhere Bildauflösung bei kürzeren Aufnahmezeiten ermöglicht, führt jedoch zu erhöhten Feldinhomogenitäten und einer spezifischen Absorptionsrate. Neuartige Methoden, die am INM-4 entwickelt wurden, begegnen diesen Herausforderungen, führen jedoch zu einer deutlich höheren Komplexität der Rekonstruktion und zu nicht rechtfertigbaren langen Rekonstruktionszeiten.

Die Lösung

Um diese zu langen Rekonstruktionszeiten zu beheben, optimierte INM-4 in Zusammenarbeit mit dem Simulation and Data Lab Neuroscience seinen Rekonstruktionscode für HPC am JSC. Durch die Implementierung einer effizienten Vorverarbeitung wurde das Rekonstruktionsproblem in einen schichtweisen Prozess umgewandelt, der parallelisiert werden konnte. In Kombination mit einer automatisierten Scheibenverarbeitung über Bash-Skripte konnte die Rechenzeit mit HPC von 320 Stunden auf 8 Stunden pro Proband reduziert werden. Dieser optimierte Arbeitsablauf überwand frühere Einschränkungen und ermöglichte die Anwendung einer neuartigen qMRt-Methode, die schnellere Scans, eine verbesserte Bildqualität und präzise parametrische Schätzungen ermöglicht. Nachfolgende Messungen an einer großen Kohorte bestätigten, dass HPC-gestützte qMRT bei UHF ein entscheidender Schritt in Richtung klinischer Durchführbarkeit ist.

Vorteile

- HPC reduzierte die Rekonstruktionszeit von 320 auf 8 Stunden pro Proband, wodurch qMRT realisierbar wurde.

- Die optimierte qMRT-Methode ermöglichte schnellere Scans, eine verbesserte Bildqualität und präzisere parametrische Schätzungen.

- Die Zusammenarbeit mit JSC verbesserte die Recheneffizienz und schuf die Voraussetzungen für KI-gestützte qMRT.

![Vergleichsdiagramm von Gehirn-MRT-Bildern, unterteilt in zwei Hauptabschnitte: Qualitatives MRT (links) und Quantitatives MRT (rechts). Unter „Qualitatives MRT“ gibt es eine Spalte mit drei graustufigen Gehirnabschnitten – axial (oben), sagittal (mittig) und koronal (unten) – die ein Strukturabbild mit willkürlicher Signalintensität zeigen. Eine Graustufen-Skala daneben reicht von -0,5 bis 0,5 und ist mit „Signal Intensity [a.u.]“ beschriftet. Unter dieser Spalte steht: „Structural image with arbitrary signal intensity.“ Der Bereich „Quantitatives MRT“ enthält vier Spalten, wobei jede die gleichen drei Gehirnansichten zeigt, jedoch mit unterschiedlichen Farbcodierungen und Messeinheiten: 1. Die erste Spalte zeigt farbkodierte Bilder von Blau (niedrig) bis Gelb (hoch), welche den „freien Wassergehalt in Prozent“ darstellen. Eine vertikale Skala rechts reicht von 0 bis 100 und ist mit „C_fw [%]“ beschriftet. Die Bildunterschrift lautet: „Free water content in percentage.“ 2. Die zweite Spalte zeigt Bilder in einer Farbskala von Blau/Grün (niedrig) bis Gelb (hoch) für die „Longitudinale Relaxationszeit in Millisekunden“, mit einer Skala von 0 bis 4000, beschriftet mit „T₁ [ms]“. Beschriftung: „Longitudinal relaxation time in milliseconds.“ 3. Die dritte Spalte verwendet eine Farbskala von Blau bis Gelb, um die „Effektive transversale Relaxationszeit in Millisekunden“ darzustellen, mit einer Skala von 0 bis 60, beschriftet mit „T₂* [ms]“. Die Beschriftung darunter lautet: „Effective transverse relaxation time in milliseconds.“ 4. Die vierte Spalte zeigt wieder Graustufenbilder, ähnlich wie beim qualitativen MRT, und stellt die „Magnetische Suszeptibilität in ppm“ dar. Die Skala reicht von -0,10 bis 0,10 und ist mit „χ [ppm]“ beschriftet. Darunter steht: „Magnetic susceptibility in ppm.“ Über den Bildern trennt eine waagerechte Linie die Überschriften: „Qualitatives MRT“ links und „Quantitatives MRT“ rechts. Jede Bilderspalte hat eine kurze, kursiv gedruckte Beschreibung des dargestellten Parameters und der jeweiligen physikalischen Einheit. Das Layout hebt den Kontrast zwischen einem einzelnen MRT-Scan mit willkürlicher Intensität und mehreren quantitativen MRT-Ansätzen hervor, die direkt kalibrierte, numerische Messwerte über die Eigenschaften des Gehirngewebes liefern.](https://supercomputing-in.de/wp-content/uploads/2025/08/QMRI-Fig2-1024x576.jpg)

Sektor der Industrie

Gesundheitswesen / Pharmazeutika / Medizinprodukte, IT-/HPC-Systeme

Wissenschaftliche Partner

Das Institut für Neurowissenschaften und Medizin 4 (INM-4) am Forschungszentrum Jülich entwickelt innovative Methoden zur Weiterentwicklung der Diagnostik und zur Verbesserung unseres Verständnisses des Gehirns mit modernster medizinischer Bildgebungstechnologie, darunter Ultrahochfeld-MRT (UHF) mit 7 Tessla. Sein interdisziplinärer Ansatz in enger Zusammenarbeit mit dem Jülich Supercomputing Center (JSC) nutzt modernste Rechenressourcen, um neuartige Bildgebungsverfahren zu entwickeln, mit denen neue Biomarker in höherer Auflösung und in kürzerer Erfassungszeit sichtbar gemacht werden können.

Wissenschaftliche Auswirkungen

Die Implementierung von qMRT bei UHF erforderte eine neuartige Bildgebungsmethode, um erhöhte Feldinhomogenitäten und spezifische Absorptionsraten zu berücksichtigen. Diese Methode ermöglichte schnellere Scans und eine verbesserte Bildqualität, erforderte jedoch die Lösung eines komplexen Rekonstruktionsproblems mit hohem Rechenaufwand. Mit herkömmlicher Hardware war die Rekonstruktion unzumutbar langsam – 8 Stunden pro Schnitt bei 160 Schnitten pro Proband –, was die Bewertung ihres klinischen Potenzials verzögerte.

Um dieses Problem zu lösen, wandte sich das Team an die Beratungsdienste des JSC und nutzte HPC, um seine Software an die Leistungsfähigkeit von HPC anzupassen. Durch die Parallelisierung von Aufgaben und die Automatisierung von Prozessen konnte die Rechenzeit von 320 auf nur 8 Stunden pro Proband reduziert werden, wodurch die Anwendung der neuartigen qMRI-Methode, die bisher durch die langsame Rekonstruktion eingeschränkt war, möglich wurde.

HPC ermöglichte somit den praktischen Einsatz der Methode und verbesserte die Bildqualität und die parametrische Genauigkeit. Damit rückt qMRT bei UHF näher an die klinische Anwendung heran und verbessert die Diagnostik. Weitere Optimierungen – wie beispielsweise die KI-gesteuerte Bildrekonstruktion – könnten es schließlich in routinemäßigen klinischen Umgebungen ohne direkten HPC-Zugang einsetzbar machen, was den Patienten durch präzisere und zeitnahe Diagnosen zugute käme.

Weiterlesen

- „(ISMRM 2023) QRAGE – Multi-Echo MPnRAGE and Model-Based Reconstruction for Quantitative MRI of Water Content, T1, T2* and Magnetic Susceptibility at 7T“. Zugegriffen: 1. Oktober 2025. [Online]. Verfügbar unter: https://archive.ismrm.org/2023/1091.html

- M. Zimmermann u. a., „QRAGE—Simultaneous multiparametric quantitative MRI of water content, T1, T2*, and magnetic susceptibility at ultrahigh field strength“, Magnetic Resonance in Medicine, Bd. 93, Nr. 1, S. 228–244, Jan. 2025, doi: 10.1002/mrm.30272.